「特徴量(説明変数)をどれだけ用意すればよい?」「学習データは何件あれば足りる?」――初学者がつまずきやすい論点を、直観と簡易ルール、よく使うモデル別の目安、失敗しないための実務チェックリストで解説します。

まずは直観:3つの軸(特徴量 p、データ数 n、モデルの複雑さ)

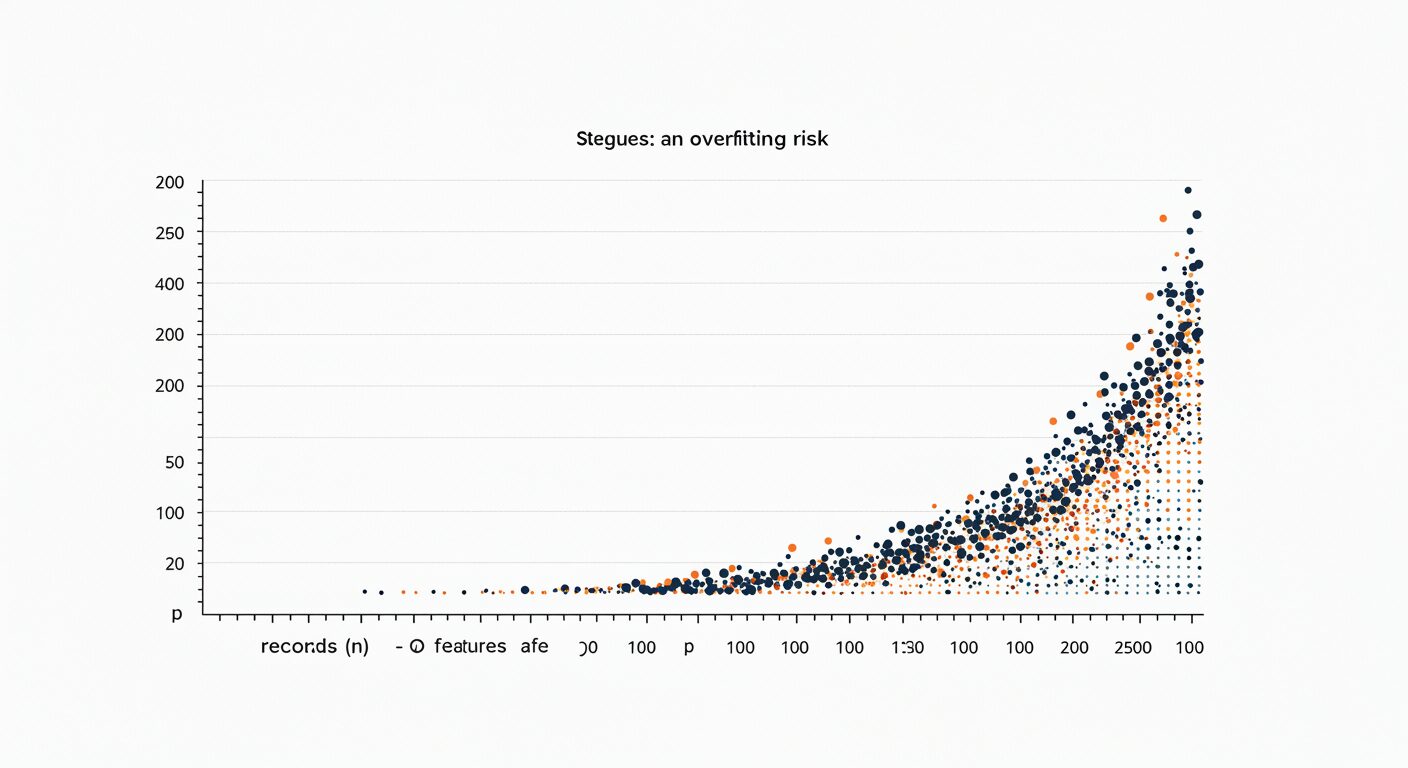

必要なレコード数は特徴量の多さ(p)とモデルの表現力(自由度)に比例して増え、許容したい誤差や汎化性能に応じて決まります。次数を上げたり大量の特徴量を入れるほど「表現力」は上がりますが、次元の呪いにより、同じ密度のデータ分布を保つにはより多くのデータが必要になります。

経験的には、p が増えるほど n は非線形的に必要になる(特に高次元)と覚えておくと安全です。

ざっくり把握するための簡易ルール

- 線形/ロジスティック回帰の素朴な目安:少なくとも

n ≧ 10p、できれば20p以上。厳密な式ではありませんが、初学者の安全側の出発点として有用です。 - 二値目的(発生/非発生)の場合:「全体件数」ではなくイベント数(発生件数)が重要。古典的には1変数あたりイベント10件(EPV=10)がよく引用されますが、状況により不足/過剰の両方があり得ます。最近は目的・許容過学習に合わせて明示的にサンプルサイズを設計することが推奨されています。

- 高次元(p ≫ n):次元削減・特徴選択・正則化(L1/L2)を前提に。元のまま学習すると過学習しやすいため、データ拡張や交差検証とセットで進めるのが基本です。

理論的には、モデルの「容量」を表す指標(例:VC 次元)に対して、汎化誤差は概ね O(√(capacity / n)) で減るといった上界が知られます。つまり、モデルが複雑になるほど、同じ誤差を達成するのにより多くの n が必要になります。

モデル別の目安と注意点

① 線形回帰・ロジスティック回帰

- 素朴な目安:パラメータ数(切片を含む)に対して

n ≧ 10p〜20pを出発点に。特にロジスティックはイベント数/変数(EPV)を意識。 - より厳密に:開発目的(予測/説明)、望む過学習の抑制度、アウトカムの頻度、想定 R2 などからサンプルサイズを設計する方法が整備されています(Rパッケージ

pmsampsizeなど)。 - 正則化:L1/L2、エラスティックネットで実効的な自由度を下げると必要 n は減らせます(ただし強いバイアスを導入)。

② 決定木・ランダムフォレスト・勾配ブースティング

- 特徴量のスケーリングに頑健で、不要特徴量にも比較的強い一方、木の深さ・学習率・木本数を大きくすると自由度が増え、n が足りないと過学習。

- 実務:早めに学習曲線を引き、「データを増やす」「正則化を強める(浅い木、木本数削減等)」のどちらが効くか確認。

③ SVM・カーネル法

- 高次元でもうまく働くことが多いですが、カーネル・ハイパーパラメータ次第では自由度が高くなり n を要します。

- 線形分離に近い場合は少ない n でも良好なことがありますが、特徴選択や次元削減は依然有効。

④ ニューラルネット

- パラメータが多く大量データ前提。画像・音声などではデータ拡張や転移学習で実効 n を稼ぐのが定石。

- 学習曲線で追加データの効きを見ながら、モデルサイズ・正則化・早期打ち切り(early stopping)を調整。

クラス不均衡と「イベント数」の考え方

二値分類で希少イベント(例:陽性5%)を扱うとき、必要なのは「全体 n」ではなく陽性の件数です。たとえばEPV=10を採用し、p=20個の説明変数を入れるなら、必要イベントは200件。陽性率5%なら総レコード数は約 200 / 0.05 = 4,000件が一つの出発点になります。

ただし EPV=10 は万能ではありません。モデルの目的や許容誤差に応じた設計(期待 R2、過学習の抑制、外的妥当性など)を使うと、より妥当な必要件数が得られます。

追加データは効く?学習曲線で判断する

学習曲線(Learning Curve)は、学習サンプル数を増やしたときの訓練/検証スコアの推移を可視化するもの。

・訓練と検証の差が大きい=高分散(過学習)→正則化強化・モデル簡素化・もっとデータ

・両者とも低い=高バイアス(表現力不足)→特徴量設計・モデル強化が有効

つまり「データを増やすべきか、モデルを変えるべきか」を、グラフで判断できます。

かんたん計算例

例1:ロジスティック回帰(陽性率10%、p=20)

- 古典目安:EPV=10 → 必要イベント数 = 10 × 20 = 200

- 総レコード数 ≒ 200 / 0.10 = 2,000

- 安全側に EPV=20 とすれば ≒ 4,000

- より厳密に:期待 R2 や目標の過学習抑制度を与えてサンプルサイズ設計(専用関数やRパッケージあり)

例2:線形回帰(p=30)

- 素朴な出発点:

n ≧ 10p = 300(できれば 600 以上) - 多重共線性が強い/ノイズが多い → 正則化(Ridge/Lasso)で実効自由度を下げる

実務チェックリスト

- データ重複・リークはないか:同一ユーザーの漏れ、時間方向の情報漏洩などは n を「見かけ上」増やすだけ。

- 特徴量の質>量:意味の薄い特徴量を増やすより、ドメイン知識に基づく特徴設計・前処理を優先。

- 検証設計:時系列は時系列CV、グループ依存はGroupKFold。汎化性能を正しく測る。

- 学習曲線の確認:「追加データ」が効くのか、「モデル/正則化」の調整が効くのかを見極める。

- 報告:p、n、イベント数、特徴量選択や正則化の方法、CV設計、外部検証の有無を明記。

よくある質問(FAQ)

Q. 結局、何件あれば十分ですか?

A. モデルの複雑さ・目的・陽性率で変わります。線形/ロジスティックなら n ≧ 10p を出発点にしつつ、学習曲線で追加データの効果を確認し、必要に応じてサンプルサイズ設計を行いましょう。

Q. EPV=10 を守れば安心?

A. 十分条件でも必要条件でもありません。データ特性や目的により過小/過大になり得ます。近年は目的に合わせた設計式で求めるのが推奨です。

Q. 特徴量が多いときは?

A. 正則化・次元削減・特徴選択を組み合わせ、まずは実効自由度を下げること。そして学習曲線で追加データの必要性を判断します。

※本記事は教育目的の概説です。用途に応じて統計的なサンプルサイズ設計や外部検証を行ってください。